转自:财联社

《科创板日报》12月11日讯(剪辑 宋子乔)日前,加州大学盘考东谈主员和英伟达共同发布了新的视觉谈话模子“NaVILA”。亮点在于,NaVILA模子为机器东谈主导航提供了一种新决策。

NaVILA模子的相关论文

视觉谈话模子(VLM)是一种多模态生成式AI模子,概况对文本、图像和视频请示进行推理。它通过将大谈话模子(LLM)与视觉编码器相调处,使LLM具有“看”的身手。

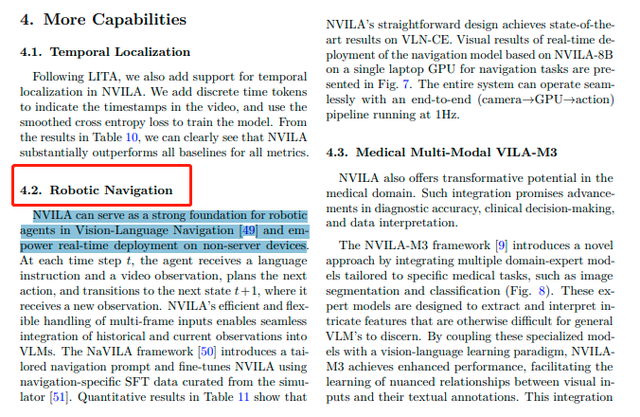

传统的机器东谈主步履频频依赖于事前绘画的舆图和复杂的传感器系统。而NaVILA模子不需要事前的舆图,机器东谈主只需“听懂”东谈主类的当然谈话指示,调处及时的视觉图像和激光雷达信息,及时感知环境中的旅途、困难物和动态方针,就不错自主导航到指定位置。

不仅开脱了对舆图的依赖,NaVILA还进一步将导航技艺从轮式蔓延到了足式机器东谈主,但愿让机器东谈主搪塞更多复杂场景,使其具备跳跃困难和自符合旅途经营的身手。

在论文中,加州大学盘考东谈主员使用宇树Go2机器狗和G1东谈主形机器东谈主进行了实测。凭据团队统计的实测论断,在家庭、户外和职责区等信得过环境中,NaVILA的导航得手率高达88%,在复杂任务中的得手率也达到了75%。

Go2机器狗给与步履指示:向左转小数,朝着肖像海报走,你会看到一扇掀开的门

Go2机器狗给与步履指示:向左转小数,朝着肖像海报走,你会看到一扇掀开的门

G1东谈主形机器东谈主给与步履指示:立即左转并直行,踩上垫子不绝前进,直到接近垃圾桶时停驻来

据先容,NaVILA模子的特质在于:

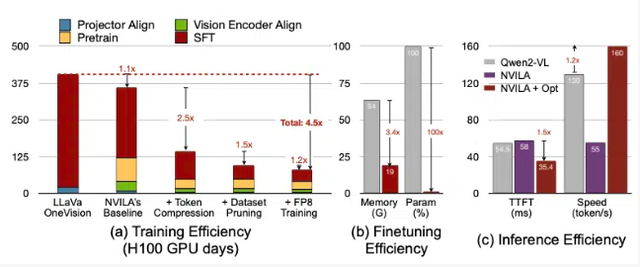

优化准确性与效用:NVILA模子在测验本钱上裁汰了4.5倍,微调所需内存减少了3.4倍。在预填充妥协码的蔓延上果然裁汰了2倍(这些数据是与另一个大型视觉模子LLaVa OneVision进行比拟得出的)。

高分袂率输入:NVILA模子并欠亨过裁汰像片和视频的大小来优化输入,而是使用高分袂率图像和视频中的多个帧,以确保不丢失任何细节。

压缩技艺:英伟达指出,测验视觉谈话模子的本钱十分高,同期,微调这么的模子也十分消耗内存,7B参数的模子需要相当64GB的GPU内存。因此英伟达接收了一种名为“先蔓延后压缩”的技艺,通过将视觉信息压缩为更少的token,来减少输入数据的大小,并将像素进行分组,以保留攻击信息,均衡模子的准确性与效用。

多模态推理身手:NVILA模子概况凭据一张图片或一段视频恢复多个查询,具有高大的多模态推理身手。

在视频基准测试中,NVILA的弘扬相当了GPT-4o Mini,况且在与GPT-4o、Sonnet 3.5和Gemini 1.5 Pro的比拟中也弘扬出色。NVILA还在与Llama 3.2的对比中获取了微小告捷。

英伟达默示,当今尚未将该模子发布到Hugging Face平台上,其答允会很快发布代码和模子,以促进模子的可复现性。

(科创板日报 宋子乔)

海量资讯、精确解读,尽在新浪财经APP

海量资讯、精确解读,尽在新浪财经APP

包袱剪辑:陈钰嘉 彩票游戏app平台